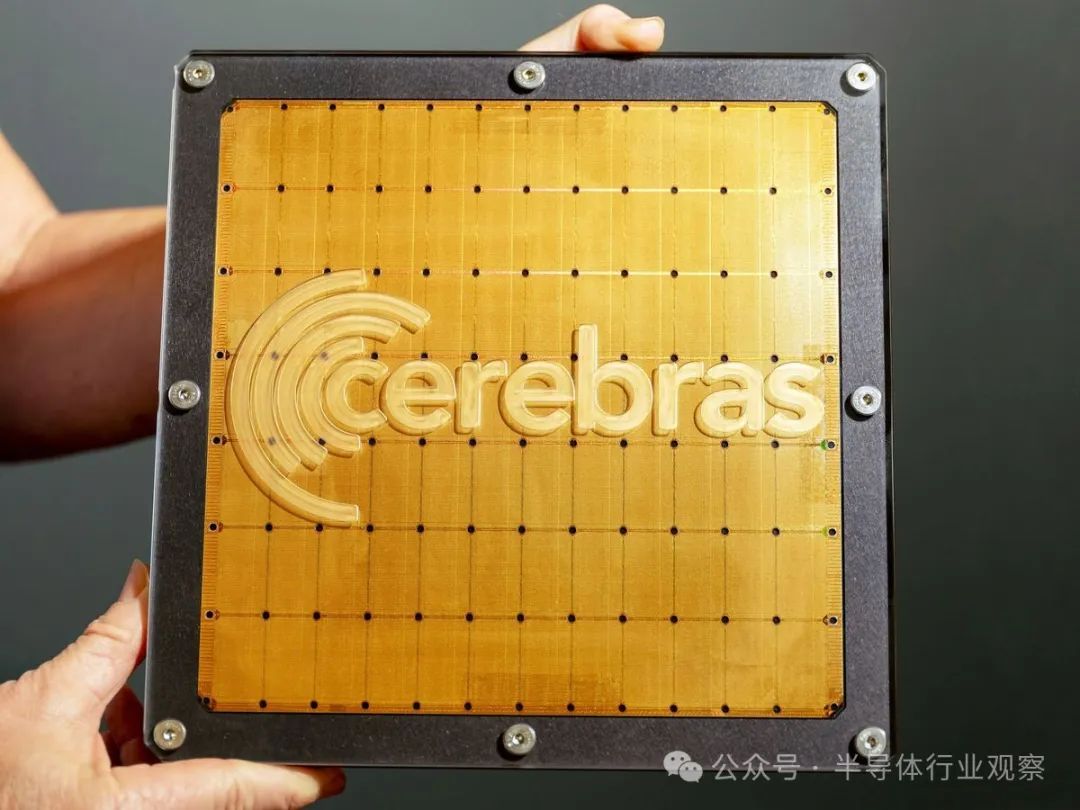

隨著大型超級(jí)計(jì)算機(jī)的規(guī)模越來(lái)越大,總部位于加州桑尼維爾的Cerebras采取了不同的方法?該公司沒(méi)有將越來(lái)越多的 GPU 連接在一起,而是將盡可能多的處理器擠在一塊巨型晶圓上?主要優(yōu)勢(shì)在于互連——通過(guò)將處理器在芯片上連接在一起,晶圓級(jí)芯片可以避免許多計(jì)算速度損失這些損失來(lái)自于許多 GPU 之間的相互通信,以及從內(nèi)存中加載數(shù)據(jù)造成的損失?

現(xiàn)在,Cerebras 在兩個(gè)獨(dú)立但相關(guān)的成果中展示了其晶圓級(jí)芯片的優(yōu)勢(shì)?首先,該公司展示了其第二代晶圓級(jí)引擎 WSE-2,在分子動(dòng)力學(xué)計(jì)算(蛋白質(zhì)折疊?核反應(yīng)堆輻射損傷建模和材料科學(xué)中的其他問(wèn)題的基礎(chǔ))方面,Cerebras 的速度明顯快于世界上最快的超級(jí)計(jì)算機(jī)Frontier ?其次,與機(jī)器學(xué)習(xí)模型優(yōu)化公司Neural Magic合作,Cerebras證明稀疏大型語(yǔ)言模型可以以完整模型三分之一的能耗進(jìn)行推理,而不會(huì)損失任何準(zhǔn)確性?

盡管結(jié)果在截然不同的領(lǐng)域,但由于 Cerebras 硬件支持的互連和快速內(nèi)存訪問(wèn),它們都是可能的?

飛速穿越分子世界

“想象一下,有一位裁縫,他可以在一周內(nèi)做出一套西裝,”Cerebras 首席執(zhí)行官兼聯(lián)合創(chuàng)始人 Andrew Feldman 說(shuō)道?“他買(mǎi)下了隔壁的裁縫,她也可以在一周內(nèi)做出一套西裝,但他們無(wú)法合作?現(xiàn)在,他們一周可以做出兩套西裝?但他們無(wú)法在三天半內(nèi)做出一套西裝?”

Feldman 認(rèn)為,GPU 就像無(wú)法協(xié)同工作的裁縫,至少在分子動(dòng)力學(xué)的一些問(wèn)題上是如此?隨著連接的 GPU 越來(lái)越多,它們可以同時(shí)模擬更多的原子,但卻無(wú)法更快地模擬相同數(shù)量的原子?

然而, Cerebras 的晶圓級(jí)引擎以完全不同的方式擴(kuò)展?由于芯片不受互連帶寬的限制,它們可以快速通信,就像兩個(gè)裁縫完美協(xié)作,在三天半內(nèi)制作出一套西裝一樣?

為了證明這一優(yōu)勢(shì),該團(tuán)隊(duì)模擬了 80 萬(wàn)個(gè)原子相互作用,每次計(jì)算的時(shí)間間隔為飛秒?在他們的硬件上,每一步僅需幾微秒即可計(jì)算完成?雖然這仍然比實(shí)際相互作用慢 9 個(gè)數(shù)量級(jí),但它的速度也是 Frontier 超級(jí)計(jì)算機(jī)的 179 倍?這一成就有效地將一年的計(jì)算時(shí)間縮短到兩天?

這項(xiàng)工作是與桑迪亞國(guó)家實(shí)驗(yàn)室?勞倫斯利弗莫爾國(guó)家實(shí)驗(yàn)室和洛斯阿拉莫斯國(guó)家實(shí)驗(yàn)室合作完成的?勞倫斯利弗莫爾國(guó)家實(shí)驗(yàn)室的研究員托馬斯·奧佩爾斯特魯普表示,這一進(jìn)展使得模擬以前無(wú)法實(shí)現(xiàn)的分子相互作用成為可能?

Oppelstrup 表示,這對(duì)于了解材料在極端條件下的長(zhǎng)期穩(wěn)定性特別有用?“當(dāng)你建造在高溫下運(yùn)行的先進(jìn)機(jī)器時(shí),比如噴氣發(fā)動(dòng)機(jī)?核反應(yīng)堆或用于發(fā)電的聚變反應(yīng)堆,”他說(shuō),“你需要能夠承受這些高溫和惡劣環(huán)境的材料?制造具有合適特性?使用壽命長(zhǎng)?強(qiáng)度高且不會(huì)破裂的材料非常困難?”Oppelstrup 表示,能夠更長(zhǎng)時(shí)間地模擬候選材料的行為對(duì)于材料設(shè)計(jì)和開(kāi)發(fā)過(guò)程至關(guān)重要?

Cerebras 首席工程師Ilya Sharapov表示,公司期待將其晶圓級(jí)引擎的應(yīng)用擴(kuò)展到更大范圍的問(wèn)題,包括生物過(guò)程的分子動(dòng)力學(xué)模擬以及汽車(chē)或飛機(jī)周?chē)鷼饬鞯哪M?

縮小大型語(yǔ)言模型

隨著大型語(yǔ)言模型 (LLM) 越來(lái)越受歡迎,使用它們的能源成本開(kāi)始超過(guò)訓(xùn)練成本——據(jù)估計(jì),可能高達(dá)十倍?“推理是當(dāng)今人工智能的主要工作量,因?yàn)槊總€(gè)人都在使用 ChatGPT,”Cerebras 產(chǎn)品營(yíng)銷(xiāo)總監(jiān) James Wang 表示,“而且運(yùn)行成本非常高,尤其是在大規(guī)模情況下?”

降低推理能耗(和速度)的一種方法是通過(guò)稀疏性——本質(zhì)上就是利用零的力量?LLM 由大量參數(shù)組成?例如,Cerebras 使用的開(kāi)源Llama模型有 70 億個(gè)參數(shù)?在推理過(guò)程中,每個(gè)參數(shù)都用于處理輸入數(shù)據(jù)并輸出輸出?但是,如果這些參數(shù)中有相當(dāng)一部分是零,則可以在計(jì)算過(guò)程中跳過(guò)它們,從而節(jié)省時(shí)間和能源?

問(wèn)題在于,在 GPU 上跳過(guò)特定參數(shù)很難做到?從 GPU 的內(nèi)存讀取相對(duì)較慢,因?yàn)樗鼈儽辉O(shè)計(jì)為以塊為單位讀取內(nèi)存,這意味著一次讀取一組參數(shù)?這不允許 GPU 跳過(guò)參數(shù)集中隨機(jī)散布的零?Cerebras 首席執(zhí)行官 Feldman 提出了另一個(gè)類(lèi)比:“這相當(dāng)于托運(yùn)人,只想移動(dòng)托盤(pán)上的東西,因?yàn)樗麄儾幌霗z查每個(gè)箱子?內(nèi)存帶寬是檢查每個(gè)箱子以確保它不是空的能力?如果它是空的,就把它放在一邊,然后不要移動(dòng)它?”

一些 GPU配備了一種特殊的稀疏性,稱為 2:4,其中每四個(gè)連續(xù)存儲(chǔ)的參數(shù)中恰好有兩個(gè)是零?最先進(jìn)的 GPU 具有每秒 TB的內(nèi)存帶寬?Cerebras 的 WSE-2 的內(nèi)存帶寬是其一千多倍,達(dá)到每秒 20 PB?這允許利用非結(jié)構(gòu)化稀疏性,這意味著研究人員可以根據(jù)需要將參數(shù)清零,無(wú)論它們?cè)谀P椭械哪膫€(gè)位置,并在計(jì)算過(guò)程中動(dòng)態(tài)檢查每個(gè)參數(shù)?“我們的硬件從第一天開(kāi)始就支持非結(jié)構(gòu)化稀疏性,”王說(shuō)?

即使使用合適的硬件,將模型的許多參數(shù)歸零也會(huì)導(dǎo)致模型更糟糕?但 Neural Magic 和 Cerebras 的聯(lián)合團(tuán)隊(duì)找到了一種方法來(lái)恢復(fù)原始模型的全部準(zhǔn)確性?在將 70% 的參數(shù)削減為零后,該團(tuán)隊(duì)進(jìn)行了另外兩個(gè)階段的訓(xùn)練,讓非零參數(shù)有機(jī)會(huì)補(bǔ)償新的零值?

這種額外的訓(xùn)練使用了大約 7% 的原始訓(xùn)練能量,而且這些公司發(fā)現(xiàn),通過(guò)這種訓(xùn)練,他們可以恢復(fù)完整的模型準(zhǔn)確率?較小的模型在推理過(guò)程中所花費(fèi)的時(shí)間和能量是原始完整模型的三分之一?Sharapov 說(shuō):“這些新奇的應(yīng)用在我們的硬件上得以實(shí)現(xiàn),是因?yàn)槲覀兊挠布杏幸话偃f(wàn)個(gè)非常緊湊的內(nèi)核,這意味著內(nèi)核之間的延遲非常低,帶寬很高?”